Subtítulos generativos: de la palabra a la comprensión

03 sept. 2024

8 minutos de lectura

8 minutos de lectura

El año pasado, escribí un blog sobre localización de vídeo. Un año es un tiempo tremendamente largo en tecnología. En realidad, es un tiempo tremendamente largo para cualquier cosa. En los últimos 12 meses, Cabo Verde fue el primer país subsahariano declarado libre de malaria por la OMS en 50 años. La reina Margarita de Dinamarca abdicó el trono, lo que supone que no quede ninguna soberana reinante en el mundo. Japón se convirtió en el quinto país en hacer aterrizar una nave espacial en la luna. Y TikTok se convirtió en la tercera plataforma de redes sociales más descargada del mundo.

Parece que, pase lo que pase, seguimos grabando vídeos de todo. Statista nos indica que se espera que el contenido multimedia genere 1,6 billones de dólares en ingresos en 2024 y que esa cifra seguirá creciendo. Los consumidores se están acostumbrando cada vez más a recibir información en vídeos breves o a tener cualquier película que deseen al alcance de la mano. También trabajamos las 24 horas del día grabando reuniones (si quieres que te dé un consejo, he descubierto un truco increíble para ahorrar tiempo: me salto las reuniones en las que no tengo nada que aportar y luego veo las grabaciones a una velocidad 1,5 veces mayor).

Al mismo tiempo, la tecnología de IA avanza a pasos agigantados. Todavía estoy esperando a que se encargue de mis tareas domésticas: ¿cuándo tendremos una Roomba que pueda aspirar escaleras? Pero, mientras tanto, podemos seguir desarrollando nuevas formas de aumentar la productividad, aumentar la calidad y ahorrar dinero.

El conocimiento humano continúa aumentando su valor a medida que la IA se prepara para tomar el control de nuestras tareas más insignificantes. Pero eso significa que la localización de vídeo sigue siendo un campo muy caro y especializado. ¿Por qué? Bueno, voy a hacer trampa y a copiar la respuesta directamente del blog del año pasado:

- Es una tarea muy compleja. Existen aplicaciones especializadas diseñadas para que los profesionales puedan desempeñar esta labor.

- Los subtítulos son difíciles de traducir. Hay limitaciones en cuanto a la longitud del texto, el texto tiene que ajustarse al vídeo, las frases se cortan por las pausas o los cambios de escena... y la lista continúa. Existen muchos motivos por los que suelen ser profesionales los que se encargan de esta tarea.

- La traducción automática no funciona bien con los fragmentos de segmentos, pero los subtítulos tienen que coincidir con lo que se ve en pantalla en un vídeo.

- El control de calidad lleva mucho tiempo. Hay que ver y escuchar el vídeo varias veces, prestando atención a los subtítulos, en todos los idiomas.

- Cada milisegundo cuenta. Los espectadores se darán cuenta si el subtítulo está desfasado con respecto a la voz real.

Cuando salga la próxima temporada de El juego del calamar, quiero que esos subtítulos sean casi perfectos; por favor, Netflix, ¡asegúrate de que participen lingüistas profesionales! Sin embargo, para ese seminario web que me perdí, necesito entender el contenido sin necesidad de que ninguna escena de luz roja/luz verde me tenga al borde del asiento. Lamentablemente, con el alto coste de la localización de vídeo, esos seminarios web no cuentan con grandes presupuestos, por lo que normalmente no subtitulan ni se localizan… ¡hasta ahora!

Presentamos la nueva función de subtítulos generativos de Trados

Con los subtítulos generativos puedes crear rápidamente un proyecto de traducción en la nube para tu vídeo (mediante el portal de clientes o un conector integrado) y, a continuación, ver con asombro cómo se generan los subtítulos automáticamente, respetando las prácticas recomendadas del sector. Basta con añadir una instrucción personalizada para garantizar que tu nombre se escriba correctamente cuando el presentador con acento sexy te presente en el vídeo.

Fantástico, ¿verdad? La mitad del problema está resuelto. Sin embargo, la localización también supone un reto. O, mejor dicho, la localización también ERA un reto.

¿Qué sucede si, en lugar de traducir fragmentos de segmentos, tomamos ese archivo de subtítulos y utilizamos un LLM para traducirlo? ¿Y si enviamos un resumen de tu vídeo a ese LLM para que tenga contexto con el que trabajar? ¿E incluso le enviamos tu terminología al mismo tiempo?

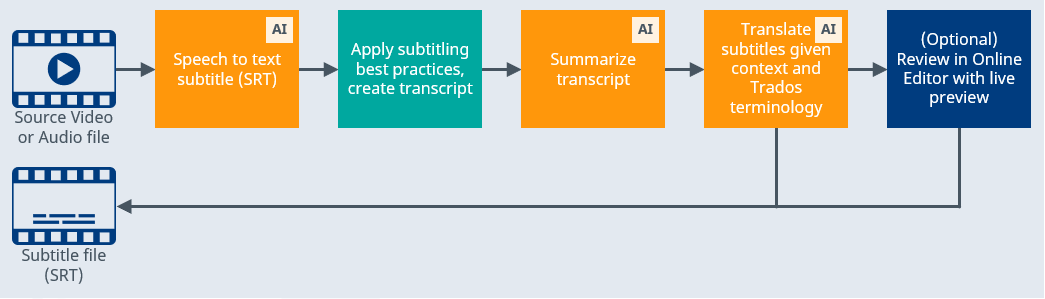

Lo has adivinado: obtienes una localización de calidad de esos subtítulos. Descubre cómo funciona:

Espera. Ese último paso, “revisión en el editor en línea con vista previa en directo”… lo has visto, ¿verdad? Qué ingenioso. Con frecuencia, para esos seminarios web, vídeos de formación y demás, basta con el proceso totalmente automatizado. Pero parece que mi jefe no habló muy claro cuando grabó sus instrucciones y soy yo quien tiene que hacerle quedar bien. Vamos a ver cómo queda.

Captura de pantalla de la previsualización en contexto en acción en el editor online

Mira cómo se produce la magia y el texto del editor online va apareciendo mientras se reproduce el vídeo, con sonido. Fíjate en cómo cambian los subtítulos en tiempo real a medida que editas el texto. Marca los segmentos para que puedas volver más tarde y preguntarle a tu jefe: «¿en qué narices estabas pensando?». O, si estás leyendo esto, Matt (mi jefe), quiero decir, para que puedas volver más tarde y felicitar a tu jefe por sus profundas ideas.

Sé que a estas alturas estarás pensando: «¡Esto suena demasiado bien para ser verdad! ¿Estoy soñando?».

Si estás escuchando esto con mi voz y viendo los subtítulos que aparecen bajo mi cabeza, la respuesta es... ¡seguramente SÍ! Pero si no, hablemos de lo habitual.

- ¿Seguridad y privacidad? ¡Cuenta con ello! Los LLM utilizados en esta fabulosa solución se alojan en el entorno de RWS Language Cloud. Tus datos nunca se hacen públicos.

- ¿Automatización del flujo de trabajo? ¡Cuenta con ello! Esta función utiliza tu entorno estándar de la nube de Trados con plantillas de proyectos, plantillas de flujos de trabajo, asignación de tareas, etc., así que, sube esos vídeos y tómate un café.

- ¿Creación de informes? ¡Cuenta con ello! Estos proyectos son como todos los demás. Seguiremos añadiendo nuevos datos para realizar un seguimiento, pero ten la seguridad de que podrás presumir de tu vertiginosa productividad.

- ¡Es increíble! A estas alturas probablemente te estés preguntando: «Querido Trados, ¿qué no puedes hacer?».

Bueno, Deadpool y Lobezno no se va a subtitular solo con Trados. Es probable que nuestros amigos de Marvel utilicen también una solución específica como la de uno de nuestros socios, CaptionHub, que les permita cambiar las marcas de tiempo, mover los subtítulos por la pantalla y traducir el florido lenguaje de Deadpool de forma más coloquial.

¿Quieres ver los resultados? Nuestros vídeos de Elevate se han subtitulado y localizado con esta solución.

¿Quieres verlo en la práctica? Ponte en contacto con tu gestor de cuentas para solicitar una demostración... y asegúrate de traer palomitas, ya que los archivos multimedia se convertirán en tu nuevo tipo de archivo favorito.